Метод опорных векторов (SVM) - один из самых мощных и широко используемых методов машинного обучения для задач классификации и регрессии. Он позволяет эффективно разделять данные путем поиска оптимальной гиперплоскости, которая максимально разделяет классы в пространстве признаков.

Правильная настройка параметров SVM играет ключевую роль в достижении высокого качества модели. В данной статье мы рассмотрим подробное руководство по настройке SVM, чтобы помочь вам получить максимальную производительность от этого метода машинного обучения.

Мы рассмотрим шаги по выбору подходящего ядра, настройке параметров регуляризации, выборе функции потерь и другие важные аспекты, необходимые для эффективной работы с SVM. После чтения этой статьи вы сможете оптимально настроить SVM для своей конкретной задачи и достичь высокой точности предсказаний.

Как настроить SVM для машинного обучения

1. Подготовка данных

Перед началом настройки SVM необходимо правильно подготовить данные. Это включает в себя очистку данных от выбросов, стандартизацию и нормализацию признаков, а также разделение данных на обучающий и тестовый наборы.

2. Выбор ядра

SVM позволяет использовать различные ядра для классификации данных. Выбор подходящего ядра (линейного, полиномиального, радиального базисного функционала и т. д.) зависит от особенностей данных и требуемой задачи. Экспериментируйте с разными ядрами, чтобы найти оптимальное.

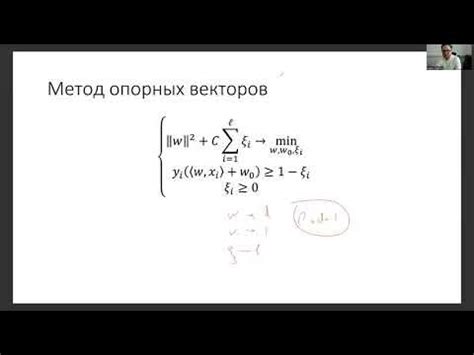

3. Настройка параметров

Для эффективной работы SVM необходимо правильно настроить параметры, такие как C и gamma. Параметр C контролирует штраф за нарушение зазора, а параметр gamma определяет влияние каждого обучающего примера. Оптимальные значения параметров помогут достичь высокой точности и обобщающей способности модели.

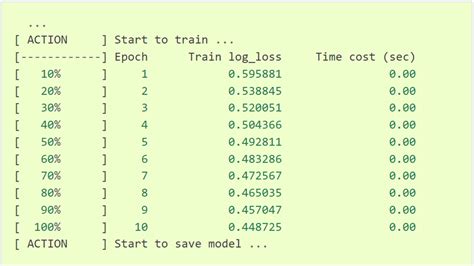

4. Обучение модели

После настройки параметров SVM проводится обучение модели на обучающем наборе данных. Оцените качество модели на тестовом наборе и проведите кросс-валидацию для оценки ее производительности.

5. Оценка результатов

После обучения модели SVM оцените полученные результаты с помощью метрик, таких как точность, полнота, F-мера и ROC-кривая. Анализируйте результаты и вносите коррективы при необходимости для улучшения производительности модели.

Выбор и подготовка данных для обучения

Сначала необходимо определиться с целями и задачами модели. Необходимо проанализировать, какие данные будут составлять обучающую выборку, какие признаки будут использоваться для обучения модели.

Далее следует провести предварительный анализ данных: изучить структуру данных, обработать пропущенные значения, удалить лишние признаки, проанализировать распределение классов (в случае задачи классификации).

| Шаг | Описание |

|---|---|

| Выбор признаков | Определить набор признаков, которые будут использованы для обучения модели. |

| Обработка пропущенных значений | Заменить пропущенные значения либо удалить строки или столбцы с пропущенными значениями. |

| Удаление лишних признаков | Избавиться от признаков, которые не несут важной информации для обучения модели. |

Подготовка данных для обучения модели SVM играет ключевую роль в успешном построении модели. Тщательный анализ данных и их корректная обработка помогут получить более качественные результаты на выходе.

Определение ядра для SVM

- Линейное ядро: простейшее ядро, которое строит разделяющую гиперплоскость в пространстве признаков.

- Полиномиальное ядро: используется для работы с нелинейными данными и включает параметр степени полинома.

- Радиальное базисное функциональное (RBF) ядро: одно из наиболее популярных ядер, которое позволяет учитывать расстояние между точками при построении разделяющей гиперплоскости.

- Сигмоидное ядро: применяется для нелинейных данных и моделирует сложные отношения между признаками.

Выбор подходящего ядра зависит от специфики данных и задачи классификации. Экспериментирование с различными ядрами и их параметрами может помочь достичь оптимальной производительности модели SVM.

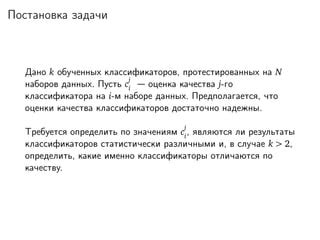

Определение гиперпараметров модели

Для эффективной настройки SVM необходимо определить гиперпараметры модели, которые влияют на ее качество и производительность. Гиперпараметры SVM включают в себя параметр регуляризации C, тип ядра (линейное, полиномиальное, радиальное базисное функциональное (RBF) и т. д.), коэффициенты ядра (если применяется полиномиальное ядро) и т. д.

Для определения оптимальных значений гиперпараметров можно использовать кросс-валидацию. Этот метод позволяет оценить качество модели на разных наборах данных, что поможет выбрать наилучшие значения гиперпараметров. Также можно применить методы оптимизации, такие как GridSearchCV, RandomizedSearchCV и т. д., для перебора различных комбинаций гиперпараметров и выбора наилучшей.

Важно учитывать, что определение гиперпараметров модели является ключевым этапом в создании эффективной модели SVM, поэтому рекомендуется проводить тщательный анализ и эксперименты для достижения оптимальных результатов.

Обучение модели на обучающем наборе данных

После того как мы подготовили данные и выбрали модель SVM, пришло время обучить модель на обучающем наборе данных. Этот этап включает в себя передачу обучающих признаков и классов в модель, чтобы она могла извлечь закономерности и создать оптимальную разделяющую гиперплоскость.

Для этого используем метод fit() модели SVM, передавая ему обучающие данные. После обучения модели можно приступать к проверке ее точности на тестовом наборе данных. Подбор и настройка параметров модели могут потребовать несколько итераций, чтобы достичь оптимальных результатов.

Оценка качества модели на тестовом наборе данных

После того как модель SVM обучена на обучающем наборе данных, необходимо оценить ее качество на тестовом наборе данных. Для этого можно воспользоваться различными метриками, такими как точность (accuracy), полнота (recall), F-мера (F1-score) и другие.

Для оценки качества модели на тестовом наборе данных можно использовать функцию predict для получения предсказанных значений и сравнения их с фактическими значениями из тестового набора данных. Затем можно вычислить метрики качества, чтобы оценить производительность модели.

Помните, что оценка качества модели на тестовом наборе данных позволяет проверить правильность работы модели и ее способность обобщать на новые данные.

Оптимизация гиперпараметров для улучшения модели

Существует несколько методов оптимизации гиперпараметров, таких как сеточный поиск, случайный поиск, оптимизация с использованием алгоритмов генетического программирования и байесовская оптимизация. Каждый из этих методов имеет свои преимущества и недостатки, поэтому выбор подходящего метода зависит от конкретной задачи и доступных ресурсов.

Сеточный поиск является одним из самых распространенных методов и заключается в переборе заданных значений гиперпараметров и оценке результатов на кросс-валидации. Данный метод позволяет найти оптимальные значения параметров, однако может быть ресурсоемким при большом количестве параметров.

Случайный поиск предполагает выбор случайных значений гиперпараметров и оценку результатов. Этот метод более эффективен при большом пространстве поиска и менее ресурсоемок, чем сеточный поиск.

Байесовская оптимизация основана на построении модели вероятности качества модели в зависимости от гиперпараметров. Этот метод позволяет учитывать информацию о предыдущих итерациях и более эффективно исследовать пространство поиска.

Выбор оптимального метода оптимизации гиперпараметров зависит от особенностей данных и постановки задачи. После нахождения оптимальных значений параметров рекомендуется провести повторную кросс-валидацию для оценки качества модели.

Интерпретация результатов SVM

После завершения обучения нашей модели SVM необходимо проанализировать результаты для оценки ее эффективности и работоспособности. Для этого осмотрим следующие параметры:

- Доля правильных предсказаний (accuracy): показывает процент правильно классифицированных объектов. Чем выше значение, тем лучше качество модели.

- Матрица ошибок (confusion matrix): позволяет оценить, какие ошибки совершает модель при классификации объектов. Из нее можно вычислить такие метрики как precision, recall, F1-score.

- ROC-кривая: позволяет оценить качество классификации модели путем анализа торгового компромисса между истинно положительными и ложно-положительными результатами.

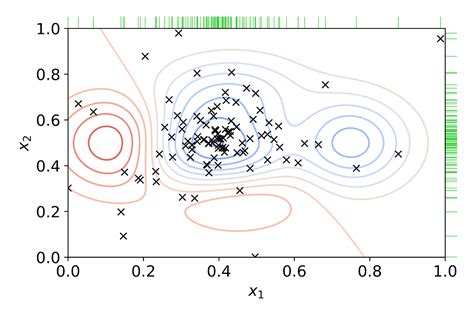

- Визуализация разделяющей гиперплоскости: помогает наглядно представить, как модель разделяет классы в пространстве признаков.

Применение обученной модели для прогнозирования

После завершения обучения модели SVM с использованием оптимальных параметров, мы можем применить эту модель для прогнозирования новых данных. Для этого необходимо подготовить входные данные в соответствии с форматом, который был использован при обучении модели.

После подготовки данных необходимо загрузить обученную модель SVM, вызвать предсказание для новых данных и получить результат вычислений. Прогнозирование с использованием SVM позволяет получить высокую точность предсказаний на основе обученной модели.

Следует помнить, что успешное применение модели SVM для прогнозирования требует внимательного подбора параметров и обучения модели на достаточно репрезентативном наборе данных. Корректное использование модели позволит получить ценные прогностические результаты и использовать их для принятия решений в различных областях приложений машинного обучения.

Вопрос-ответ

Как выбрать параметр регуляризации C при настройке SVM?

При выборе параметра регуляризации C нужно учитывать баланс между обобщающей способностью модели и ее склонностью к переобучению. Большие значения C приводят к более сложным моделям, которые могут быть чувствительны к переобучению, тогда как малые значения C могут привести к недообученной модели. Оптимальное значение C обычно выбирается путем кросс-валидации.

Какие ядра часто используются при настройке SVM?

В сфере машинного обучения часто используются следующие ядра при настройке SVM: линейное, радиальное базисное функционирование (RBF) и полиномиальное. Линейное ядро подходит для простых данных, RBF ядро хорошо справляется с нелинейными данными, а полиномиальное ядро используется для данных с нелинейной структурой, но не настолько сложной, чтобы требовать RBF.