Погружение во вселенную Кафки приковывает взгляд и увлекает в омут интересных открытий. Поражает каждый тонкий миг, каждое мгновение, начиная от его первого взмаха и до дрожащего конца. Это запутанный и изощренный мир, где трансформация и преображение лежат в центре руки предприимчивого наблюдателя.

Сонм необычных возможностей чествует величие Кафки, важность его рольтонов и неоизведанные возможности трансформации окружающего мира. Каждая частица его существования скрыта в себе необычайную силу, наполняющую все пространство невидимых нитей и связей.

Подобно замысловатому парадоксу истина о Кафке манит своей загадкой и шифрует суть в своих лабиринтах. Великолепие его состоит в напрашивающемся шорохе непонятности, где каждая заглавная буква словет связана с миллионом вопросов и растекается как импульс размышления, распыляясь на мириады возможностей и истоков.

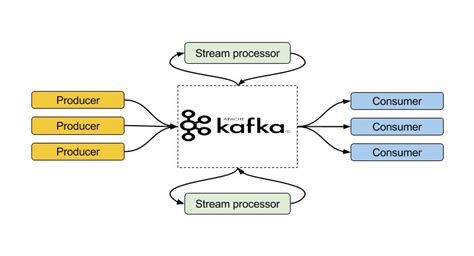

Устройство и основные принципы функционирования Apache Kafka

В основе архитектуры Kafka лежат несколько ключевых компонентов, каждый из которых выполняет специфическую задачу в процессе обработки данных:

- Брокеры (Kafka brokers): это основные узлы, ответственные за хранение и обработку данных. Каждый брокер представляет собой отдельный сервер, который может обмениваться информацией с другими брокерами и участвовать в кластере Kafka.

- Топики (Topics): это единицы организации и классификации данных в Kafka. Каждый топик представляет собой логическую категорию данных, на которую можно осуществлять запись и из которой можно читать. Топики в Kafka разделены на несколько партиций.

- Партиции (Partitions): это физические единицы хранения данных внутри топика. Каждая партиция представляет собой упорядоченную последовательность сообщений и имеет уникальный идентификатор (offset), по которому можно осуществлять чтение и запись данных.

- Производители (Producers): это компоненты, отвечающие за запись данных в Kafka. Производитель может отправлять сообщения в определенный топик или в несколько топиков одновременно.

- Консьюмеры (Consumers): это компоненты, осуществляющие чтение данных из Kafka. Консьюмер может подписаться на один или несколько топиков и получать новые сообщения при их поступлении.

Основной принцип работы Apache Kafka заключается в асинхронной отправке и чтении данных, а также в возможности горизонтального масштабирования. Данные, производимые производителями, сохраняются в топиках и разделены на партиции для обеспечения распределенности и отказоустойчивости. Консьюмеры могут выбирать, с какой партиции начинать чтение, и получать данные в режиме реального времени.

Архитектура Apache Kafka

В данном разделе рассмотрим архитектуру Apache Kafka, что позволит нам получить более глубокое понимание о ее устройстве и принципах работы.

Apache Kafka представляет собой высокопроизводительную платформу для обработки и хранения потоков данных. Она основана на распределенной архитектуре и может масштабироваться горизонтально, обеспечивая высокую отказоустойчивость и пропускную способность.

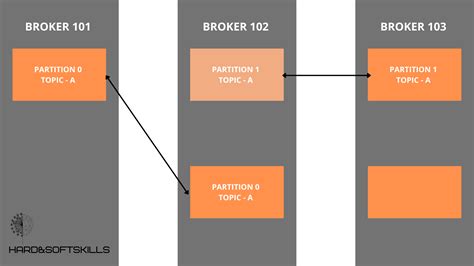

Центральным элементом архитектуры Kafka является ее брокерская модель, которая состоит из Kafka брокеров и топиков. Брокеры представляют собой узлы, ответственные за обработку и хранение сообщений. Они работают в группе, что позволяет достичь балансировки нагрузки и повышения отказоустойчивости.

Топики служат для организации и структурирования потоков данных. Они разделены на партиции, каждая из которых хранит определенное количество данных. Партиции могут быть реплицированы по разным брокерам, обеспечивая надежность и отказоустойчивость системы.

Взаимодействие с Apache Kafka осуществляется через клиентские приложения, которые публикуют и/или подписываются на топики. Клиенты могут использовать различные протоколы, такие как Kafka API или Apache Kafka Connect, для интеграции со сторонними системами.

Архитектура Kafka также включает в себя компоненты, такие как ZooKeeper и Kafka Streams. ZooKeeper отвечает за координацию брокеров и обеспечение консистентности и надежности системы. Kafka Streams предоставляет API для обработки и анализа потоков данных непосредственно на клиентской стороне.

Изучение архитектуры Apache Kafka позволяет более глубоко понять принципы работы этой мощной платформы и эффективно ее использовать в различных сценариях обработки и хранения данных.

Роли и функции компонентов в Kafka

| Компонент | Функция |

|---|---|

| Клиенты Kafka | Клиенты Kafka являются программами, которые взаимодействуют с кластером Kafka для отправки и получения сообщений. Клиенты могут быть написаны на различных языках программирования и инициируют процессы передачи данных по топикам. |

| Брокеры Kafka | Брокеры Kafka - это серверы, которые управляют хранением и передачей сообщений. Они принимают сообщения от клиентов, сохраняют их в журналы, совместно образующие разделы, и передают эти сообщения другим клиентам. Брокеры также могут выполнять репликацию данных и обеспечивать масштабируемость и отказоустойчивость системы. |

| Топики и разделы | Топики и разделы - основные концепции Kafka. Топик представляет собой категорию или канал, в который отправляются и из которого извлекаются сообщения. Разделы - это логические единицы хранения данных внутри топиков, которые можно параллельно обрабатывать и распределять между различными брокерами. |

| Зоны доступности | Зоны доступности - это физические копии разделов, которые распределяются по различным брокерам для обеспечения отказоустойчивости. Каждая зона доступности может содержать одну или несколько реплик раздела. Это позволяет Kafka продолжать работу в случае отказа одной или нескольких зон доступности. |

| Коннекторы Kafka | Коннекторы Kafka - это компоненты, которые обеспечивают интеграцию с внешними системами, позволяя отправлять и получать данные из Kafka. Коннекторы могут быть настроены для работы с различными источниками данных, такими как базы данных, потоковые платформы и т. д., и облегчают интеграцию Kafka с другими системами. |

Компоненты Kafka совместно работают для обеспечения надежной и эффективной передачи сообщений. Процесс передачи сообщений в Kafka является асинхронным и масштабируемым, что позволяет обрабатывать большие объемы данных и обеспечивать отказоустойчивость системы.

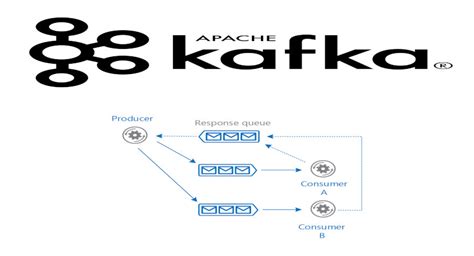

Процесс формирования записей в Kafka

Этот раздел посвящен процессу, благодаря которому сообщения записываются в систему Apache Kafka. Узнайте о ключевых компонентах и шагах, необходимых для проведения этой операции.

- Создание производителя (producer): для начала записи сообщений в Kafka необходимо создать производителя, который отвечает за генерацию и отправку данных в брокеры.

- Определение темы: после создания производителя необходимо указать тему, в которую будут записываться сообщения. Тема является категорией, в которой группируются связанные данные.

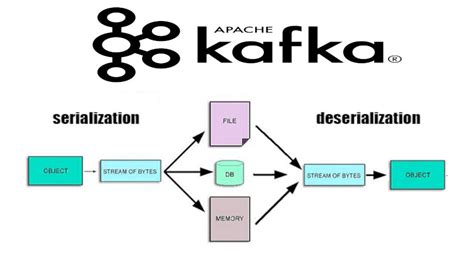

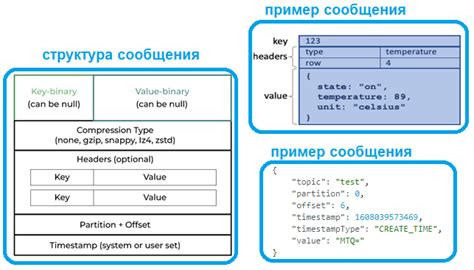

- Формирование сообщений: производитель генерирует или получает данные, которые необходимо записать. Сообщения могут быть представлены в различных форматах, таких как JSON, AVRO или бинарный формат.

- Установка ключа (опционально): в сообщениях можно указывать ключи, которые помогают определить, к какому разделу темы они будут направлены. Ключ помогает обеспечить определенный порядок обработки сообщений.

- Отправка сообщений: после формирования сообщений и, при необходимости, установки ключа, производитель отправляет данные в Kafka.

- Разделение и репликация: команда брокеров Kafka распределяет записи в различные партиции (partitions) в зависимости от ключей или методики по умолчанию. Каждая партиция может иметь несколько реплик, обеспечивающих отказоустойчивость.

- Хранение и доступность: записанные сообщения сохраняются в журнале брокера и хранятся на диске. Такая архитектура позволяет гарантировать высокую доступность данных и возможность их обработки в режиме реального времени.

Теперь вы знакомы с процессом записи сообщений в Kafka, от создания производителя до хранения данных. Понимание этого процесса поможет вам лучше использовать Kafka в ваших приложениях и системах обработки данных.

Система хранения данных в Kafka

В данном разделе мы рассмотрим, как Kafka обеспечивает эффективное хранение данных, обеспечивая высокую производительность и гарантируя сохранность информации.

Кафка предлагает прагматичный подход к хранению данных, используя собственную систему хранения. Эта система позволяет организовать данные в виде упорядоченной последовательности, называемой логом. Лог разделен на небольшие фрагменты данных, называемые партициями, которые распределены по разным брокерам в кластере Kafka. Такая архитектура не только обеспечивает масштабируемость данных, но и гарантирует отказоустойчивость и репликацию информации.

Каждая партиция лога является упорядоченной и неизменяемой последовательностью записей, которые могут быть добавлены только в конец. Важно отметить, что Kafka не удаляет старые сообщения, а лишь их архивирует. Это позволяет обеспечить сохранность данных на долгое время и предоставляет возможность повторного чтения сообщений в будущем.

Для улучшения производительности, Kafka использует смещения (offsets), которые указывают на относительное положение каждого сообщения в логе. Смещения позволяют быстро находить и читать записи, а также обеспечивают контроль над чтением и записью во время работы с логами.

Таким образом, система хранения данных в Kafka обеспечивает надежное и эффективное хранение информации, а также предоставляет механизмы для работы с упорядоченными и неразрушаемыми логами данных. Это позволяет Kafka быть одной из самых популярных систем для обработки и передачи потоковых данных.

Процесс обработки и получения сообщений в Apache Kafka

Этот раздел представляет обзор процесса чтения и потребления сообщений в Apache Kafka, мощной и масштабируемой платформе для обработки потоков данных. Мы рассмотрим, каким образом Kafka гарантирует устойчивость и надежность доставки сообщений, а также о том, как происходит процесс чтения и консьюмеров сообщений.

- Архитектура Kafka

- Топики и партиции

- Процесс чтения сообщений

- Гарантии доставки и обработки сообщений

- Масштабирование и управление пропускной способностью

Перед тем, как погрузиться в детали обработки сообщений, давайте рассмотрим общую архитектуру Kafka. Kafka имеет некоторые основные компоненты, включая брокеры Kafka, топики, продюсеры и консьюмеры. Каждый компонент выполняет свою специфическую роль для обеспечения надежности и эффективности обработки сообщений.

Топики в Kafka представляют собой категории или каналы, в которые продюсеры отправляют сообщения. Топики разбиваются на партиции, что позволяет распределить нагрузку обработки сообщений между брокерами Kafka. Каждая партиция является упорядоченным журналом записей и может быть реплицирована на несколько брокеров, чтобы обеспечить отказоустойчивость.

Консьюмеры Kafka могут читать сообщения из топиков и осуществлять обработку в режиме реального времени. Процесс чтения сообщений основан на оффсетах, которые указывают позицию в пределах партиции, с которой следует начать чтение. Консьюмеры могут контролировать свое чтение, настраивая текущий оффсет и оффсеты реплик, что позволяет достичь балансировки работы между консьюмерами и обеспечить масштабируемость.

Apache Kafka обеспечивает семантику "точно один раз" и "по крайней мере один раз". Это достигается за счет сохранения оффсетов и репликации партиций сообщений на несколько брокеров. Если какой-то брокер или консьюмер Kafka отказывает, другие брокеры и консьюмеры могут продолжать работать без потери данных.

Kafka позволяет горизонтально масштабировать потребителей для обработки большого объема сообщений. Для управления пропускной способностью и доставкой сообщений Kafka предлагает различные настройки, включая настройку партиций на топики, репликации данных, скорости чтения и записи.

Теперь, когда мы рассмотрели процесс чтения и потребления сообщений в Apache Kafka, вы сможете лучше понять, как Kafka обеспечивает надежное и эффективное передачу потоков данных в реальном времени.

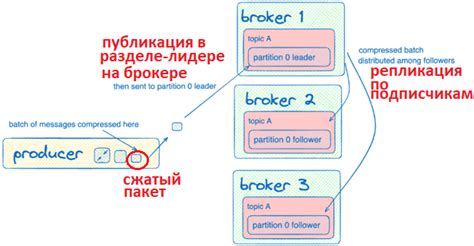

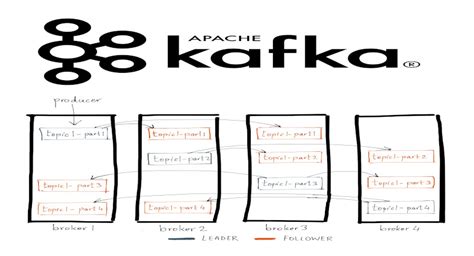

Репликация данных в Apache Kafka

Первоначально репликация данных может показаться излишне сложным процессом, однако она является неотъемлемой частью архитектуры Kafka, обеспечивая надежность и отказоустойчивость системы. Репликация позволяет создавать копии данных на нескольких брокерах Kafka, что позволяет обеспечить доступность данных даже при отказе одного или нескольких узлов.

- Репликация в Kafka базируется на понятии топиков. Каждый топик представляет собой набор сообщений, которые могут быть разделены на несколько партиций - физических записей данных на диске. Каждая партиция имеет одного лидера и ноль или несколько реплик. Лидер отвечает за чтение и запись данных, в то время как реплики служат для обеспечения отказоустойчивости данных.

- При записи сообщений в топик Kafka следит за репликацией данных на все реплики партиции. Каждая запись фиксируется на лидере и затем асинхронно реплицируется на все реплики. Это позволяет гарантировать сохранность данных даже при сбоях системы или сети.

- В случае отказа лидера, одна из реплик автоматически переходит в режим лидера и начинает обслуживать запросы на чтение и запись данных. Такой механизм позволяет обеспечить непрерывность работы системы и минимальное воздействие на производительность при отказах.

- Кроме того, репликация в Kafka позволяет создавать множество потребителей данных, которые могут активно читать данные с разных реплик партиций. Это обеспечивает масштабируемость и высокую производительность системы.

Репликация данных в Apache Kafka является важным механизмом, обеспечивающим надежность и отказоустойчивость системы. Она позволяет создавать копии данных на нескольких брокерах Kafka, обеспечивая доступность данных даже при отказе некоторых компонентов системы. Надежность и эффективность репликации делают Kafka идеальным инструментом для обработки и передачи больших объемов данных.

Использование балансировки и масштабирования в Apache Kafka

Этот раздел посвящен изучению принципов, применяемых в Apache Kafka для обеспечения эффективной балансировки нагрузки и масштабирования системы.

Apache Kafka – это распределенная платформа обработки данных, которая предоставляет производителям и потребителям независимые потоки данных через тематические ленты (topic). Балансировка и масштабирование играют ключевую роль в обеспечении оптимальной производительности и гарантии непрерывной передачи данных.

Балансировка нагрузки в Kafka осуществляется путем распределения партиций (partitions) между брокерами (brokers) в кластере. Каждая партиция представляет собой упорядоченный и неизменяемый поток сообщений. Кластер брокеров следит за количеством потребителей и производителей, назначая соответствующие партиции каждому участнику. Это позволяет эффективно распределять нагрузку между брокерами и обрабатывать сообщения параллельно.

Масштабирование в Kafka подразумевает увеличение пропускной способности и хранения данных. Это достигается путем добавления новых брокеров к кластеру. Кластер автоматически обновляет метаданные о распределении партиций и репликах (replicas), чтобы новые брокеры получили свою долю нагрузки. В результате система способна обрабатывать больший объем данных и справляться со значительно растущей нагрузкой.

| Преимущества балансировки и масштабирования в Kafka: |

|---|

| - Обеспечение высокой доступности и отказоустойчивости системы |

| - Распределение нагрузки между узлами кластера для повышения производительности |

| - Увеличение пропускной способности и расширение возможностей обработки данных |

| - Гарантированное сохранение сообщений даже при отказе отдельных узлов |

Гарантия надежности и устойчивости Apache Kafka

В данном разделе мы рассмотрим ключевые аспекты, обеспечивающие стабильную и надежную работу Apache Kafka.

- Отказоустойчивость: описание механизмов, позволяющих Kafka сохранять работоспособность при сбоях и отказах в системе.

- Репликация данных: изучение принципов и процессов репликации, обеспечивающих сохранность данных даже при потере или повреждении некоторых компонентов системы.

- Управление трафиком: рассмотрение методов и инструментов, которые помогают балансировать и распределять нагрузку между брокерами, обеспечивая эффективное функционирование системы.

- Устойчивость к высоким нагрузкам: анализ механизмов, используемых Kafka для обработки больших объемов данных и эффективной работы при высоких нагрузках.

- Мониторинг и отслеживание: представление средств мониторинга и инструментов для отслеживания работы системы, выявления проблем и принятия мер по их устранению.

Понимание этих аспектов позволит вам обеспечить стабильную и надежную работу вашей системы на базе Apache Kafka, улучшить ее производительность и снизить риск возникновения сбоев и проблем.

Вопрос-ответ

Что такое Кафка и как она работает?

Апаче Кафка – это распределенная платформа, предназначенная для устойчивого и масштабируемого обмена данными между разными приложениями. Она основана на принципе распределенного журнала, где данные записываются и хранятся в постоянном порядке. Kafka имеет несколько ключевых компонентов: продюсеры, которые записывают данные в тему, брокеры, которые хранят и обслуживают эти данные, и потребители, которые читают данные из темы.

Какие преимущества предоставляет Кафка разработчикам?

Кафка предоставляет несколько преимуществ разработчикам. Во-первых, она обеспечивает высокую производительность и масштабируемость, что позволяет обрабатывать большие объемы данных в реальном времени. Во-вторых, она поддерживает повторяемость, что гарантирует, что данные не потеряются при сбоях системы. Кроме того, Кафка обеспечивает возможность создания потоков данных, что позволяет анализировать данные в движении и принимать решения в режиме реального времени.

Какие основные принципы работы Кафка?

Основные принципы работы Кафка включают в себя: высокую производительность благодаря использованию пакетной записи данных, возможность масштабирования путем добавления новых брокеров, гарантию хранения данных в указанном порядке благодаря журналу записи, многократную обработку данных благодаря устойчивости и повторяемости, а также возможность параллельного чтения данных.

Какую роль играют продюсеры, брокеры и потребители в работе Кафка?

Продюсеры отвечают за запись данных в темы, они отправляют сообщения в брокеры Кафки. Брокеры представляют собой сервера сообщений, которые хранят и обслуживают записанные данные. Они разделены на разные разделы (партиции), чтобы разгрузить нагрузку и достичь масштабируемости. Потребители отвечают за чтение данных из тем и обработку их.

Какие используются инструменты для работы с Кафкой?

Для работы с Кафкой можно использовать различные инструменты. Например, Kafka Connect позволяет интегрировать Кафку с различными источниками и назначениями данных. Kafka Streams предоставляет API для обработки и анализа данных в режиме реального времени. Кроме того, существуют клиентские библиотеки на разных языках программирования, таких как Java, Python и другие, для удобной работы с Кафкой в разных средах разработки.