Char и char – два термина, которые могут сбить с толку даже опытных разработчиков. В языке программирования они обозначают разные концепции, и понимание их различий – ключ к правильному использованию.

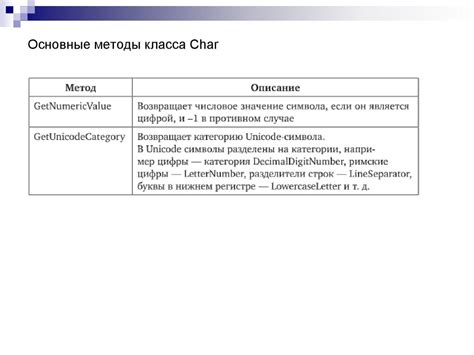

Обычно Char с большой буквы обозначает тип данных в языках программирования, таких как C#, Java или C++. Этот тип представляет собой символ или букву (библиотека Unicode) и хранит его в виде целого числа.

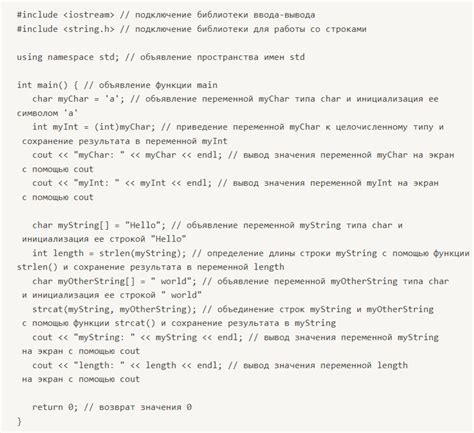

С другой стороны, char с маленькой буквы может использоваться как переменная в коде, обозначая конкретный символ или букву. Он не является ключевым словом языка и может иметь различное значение в разных контекстах.

Char и char: основные различия

char, напротив, используется в языке программирования C и означает тип данных для хранения символов ASCII. Он пишется с маленькой буквы c.

Таким образом, основное различие между Char и char заключается в том, что первое используется в Java для символов Unicode, а второе - в C для символов ASCII.

Char в C#: тип данных для символов

Char в языке программирования C# представляет собой 16-битную беззнаковую кодовую единицу Unicode. Тип данных char используется для хранения одного символа, который может быть любым символом Unicode от U+0000 до U+FFFF. Как правило, символы в языке C# заключаются в одиночные кавычки, например, 'A' или 'б'.

Особенностью типа данных char является его небольшая размерность, что делает его эффективным для хранения отдельных символов. Этот тип данных часто используется при работе с символьными данными, например, при считывании или записи символов из/в потока.

Важно помнить, что тип данных char отличается от типа данных Char, который может представлять более обширный набор символов или содержать дополнительную информацию в зависимости от контекста и используемой платформы.

char в Java: примитивный тип данных

В языке программирования Java тип данных char относится к примитивным типам, которые используются для хранения символов.

char представляет собой 16-битное целочисленное значение и может хранить один символ Unicode. Каждому символу соответствует его уникальный код, который представлен в диапазоне от '